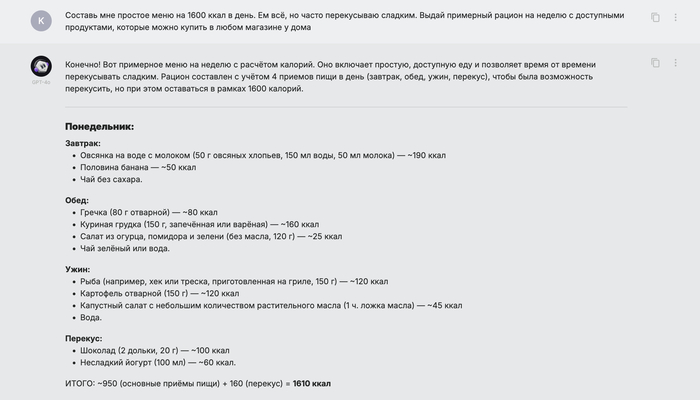

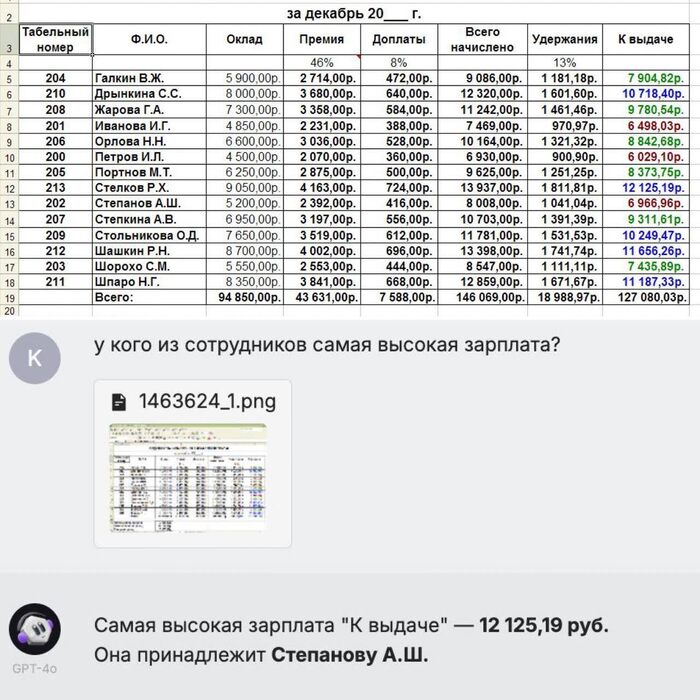

Как ИИ-аферисты создали идеальную женщину. За 2 недели она собрала 10 миллионов рублей

Она писала каждое утро: «Привет, солнце». Помнила день рождения собаки. Записывала голосовые сообщения с забавными историями. Голос дрожал, когда рассказывала, как боится операции.

Через две недели он перевёл 180 000 ₽. Потом ещё. Потом ещё. А потом — тишина. Её не существовало.

Так работают digital-romance-аферы — новый вид обмана, где нейросети играют в любовь. Но это лишь одна из трёх схем, которые ломают жизни и опустошают счета.

Давайте разберём, как ИИ делает из нас жертв. И как не попасться.

Любовь с алгоритмом

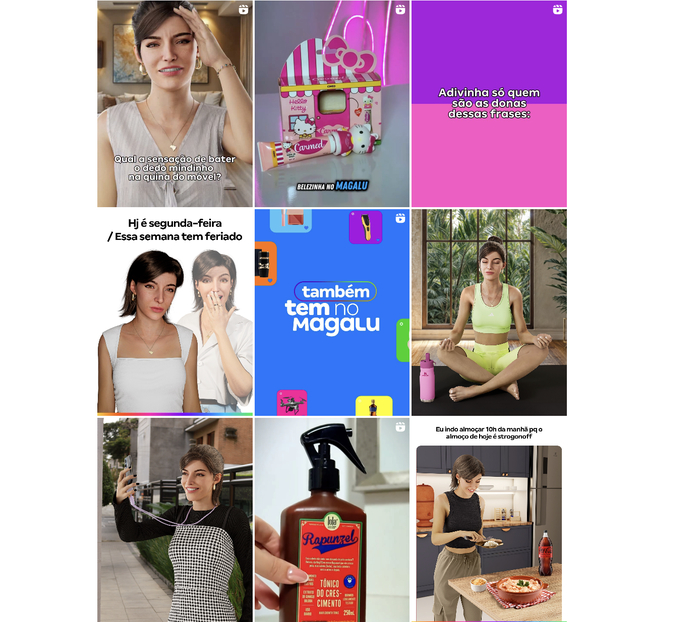

Идеальные черты лица, нежный взгляд, чуть грустная улыбка. Алгоритмы уже генерируют лица без единой ошибки. Даже добавляют лёгкие морщинки, чтобы было не отличить от реальных лиц.

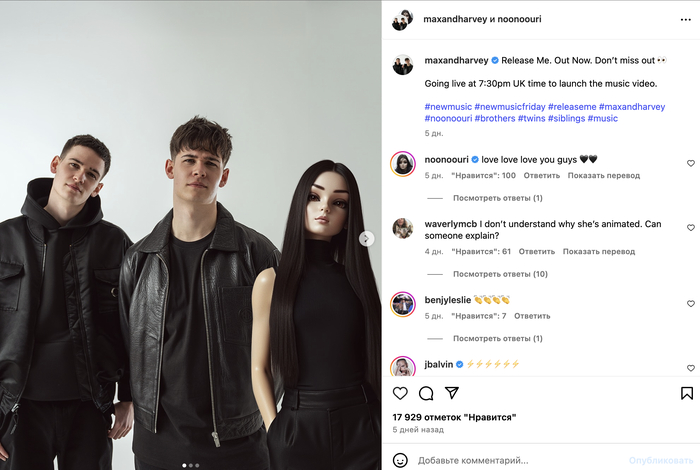

Дальше — знакомство в соцсетях. Вы пишете, она отвечает быстро и тонко чувствует эмоции. Делится тревогами, шутит, иногда ревнует.

Голос? Настоящий. Вернее, сгенерированный с помощью ElevenLabs или Voice.ai. Нужны всего 10 секунд чужого голоса, и программа сделает остальное: дыхание, интонации, даже лёгкое дрожание в голосе, будто она волнуется.

Через неделю вы уже обсуждаете совместное будущее. Через две — она «попала в аварию» или «нужны деньги на визу».

В отдельных кейсах Telegram-боты под видом «Анастасия/Настя» собирали миллионы рублей за считаные недели. Основная аудитория: мужчины 35–55, в разводе.

«Мама, я попал в аварию»

Звонок. Голос сына:

— Мама, я в больнице, помоги! Срочно нужны деньги!

Вы слышите тревогу, шум на фоне. И ни секунды не сомневаетесь: это ваш ребёнок. Но это не он. Это ИИ-клон его голоса, собранный из сторис или голосовых в чате.

Почему работает:

страх за близкого выключает критическое мышление;

плохая связь маскирует синтетические эффекты;

просьбы небольшие и «срочные», чтобы вы не советовались.

Мини-защита в семье:

кодовое слово/вопрос (как звали вашего первого учителя?);

правило: «всегда перезваниваем сами»;

отдельный семейный чат ”SOS”, где все подтверждают ситуацию.

Директор в Zoom просит перевести деньги

Корпоративная версия ИИ-обмана.

Как выглядит: вы на удалёнке, врывается экстренный видеозвонок. На экране — ваш руководитель. Говорит быстро, связь рвётся: «Нужно закрыть сделку до конца часа. Переводим партнёру, вот реквизиты». И всё — деньги ушли.

Используются: HeyGen, DeepFaceLab, Synthesia. Лицо с корпоративных трансляций, голос — из публичных выступлений.

Сигналы фейка:

разрыв синхронизации губ и звука;

«плоское» освещение, одинаковое во всех ракурсах;

руководитель избегает свободного диалога («я на совещании, просто сделайте»);

срочность + нестандартные реквизиты.

В США такие схемы привели к многомиллионным потерям. А в Азии дипфейки используются даже для фальсификации совещаний.

Мини-политика компании:

любые платежи вне утверждённого списка — только после голосового подтверждения по внутреннему номеру;

секретные «контрольные вопросы» между финансистом и руководителем;

запись всех срочных звонков и проверка.

Как распознать, что вас обманывает ИИ?

Перепроверяйте всегда. Звоните напрямую и спрашивайте, в чём дело.

Если закрадываются подозрения, просите собеседника ответить на вопрос личного характера, ответ на который знаете только вы и он.

Не действуйте под давлением. Эмоции и срочность — главное оружие мошенников. Всегда можно взять время на подумать и посоветоваться с ближним.

Доверяйте, но проверяйте — особенно, если что-то кажется «слишком хорошим».

ИИ не добрый и не злой. Он просто слишком убедительный.

И пока мы учимся делать картинки и тексты — кто-то уже учится ломать нам сердца и снимать деньги со счетов. Пора научиться защищаться.

Если уже перевели деньги

Немедленно свяжитесь с банком: запросите отмену/блок транзакции.

Заявление в полицию + скриншоты всей переписки, голосовых, реквизитов.

Проверьте устройства на вредоносные ссылки (часто романтические схемы совмещаются с установкой троянов).

Предупредите контакты: мошенники могут использовать вашу историю для цепной атаки.

Поделитесь этой статьёй — возможно, она спасёт чей-то счёт.