Лига Сисадминов

Клонируем ssd nvme рабочего ноута с адаптером ssd(nvme)<->usb-c, расширяем раздел с Win10 до 1Тб

Нужно увеличить ssd nvme на рабочем ноуте без переустановки системы, сейчас диск на 500Гб, будет на 1Тб.

Ранее мы делали перенос с hdd на ssd, также без переустановки ОС; еще измеряли скорость ssd nvme под Win/Linux.

Сейчас, когда всё готово, можно сказать, что все работы укладываются в 30-40 мин. Что было сделано заранее:

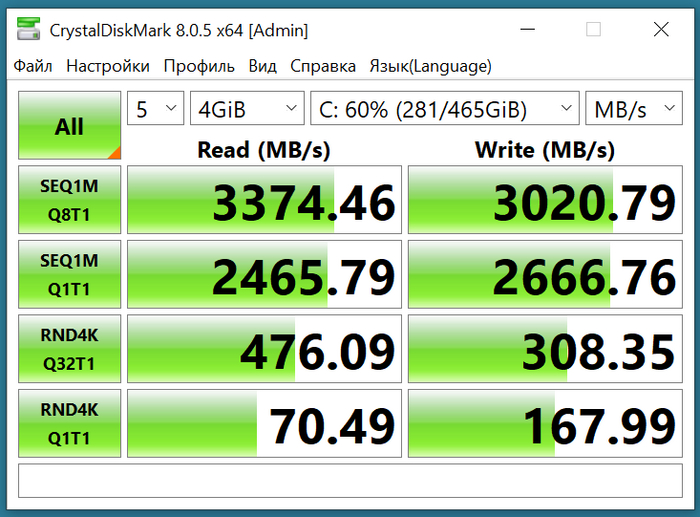

куплен новый ssd nvme 1Тб. Диск выбирался по соотношению цена/скорость. на ЯМе нашёлся Apacer SSD AS2280P4U 1TB M.2 PCIe Gen3x4 ниже 6К рублей, скорости 3500/3000, TWB 760Тб, это хорошие показатели (ранее у нас были более медленные диски)

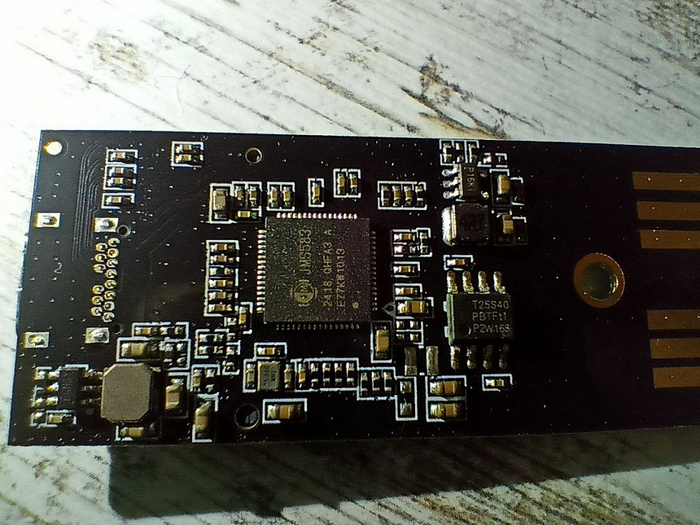

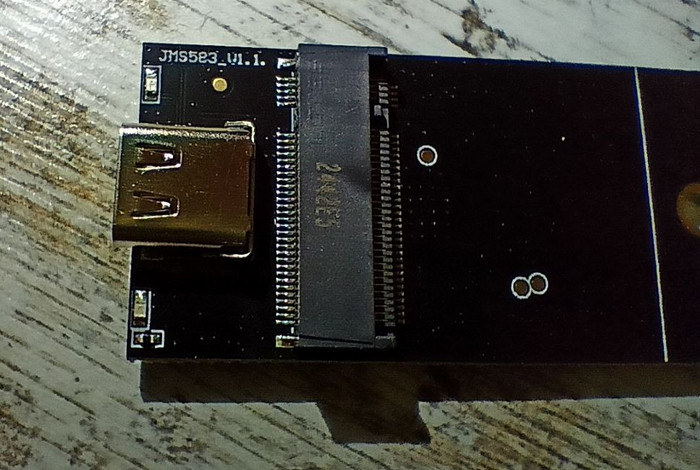

куплен адаптер ssd(nvme)<->usb-c. Адаптер куплен наугад (не реклама!), по отзывам, при цене ниже 1К рублей. Требований было 2 - поддержка nvme и интерфейс USB-C (type C)

Ниже станет понятно, что диск заявленные скорости поддерживает, адаптер также работает верно.

В ноуте Dell 7390 один разъем под nvme. Решено было купить адаптер ssd(nvme)<->usb-c в корпусе с кабелем type C, их много как на Озоне/ЯМе, так и на Али. Выбрали по отзывам, несколько фото:

Сама платка субъективно похожа на 50% того, что продаётся в 2-3 раза дешевле (без корпуса) на Али, со сроком поставки через 1-2 недели.

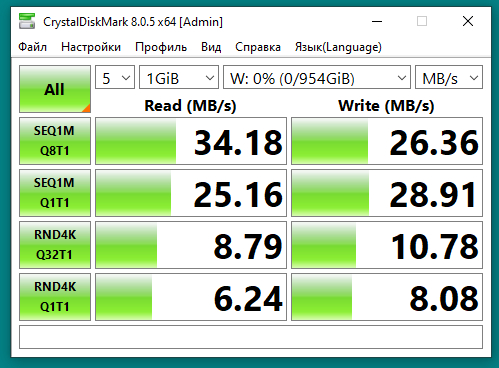

При подключении ssd с адаптером к компьютеру с usb 2.0 скорость совсем грустная, скорее из-за кабеля:

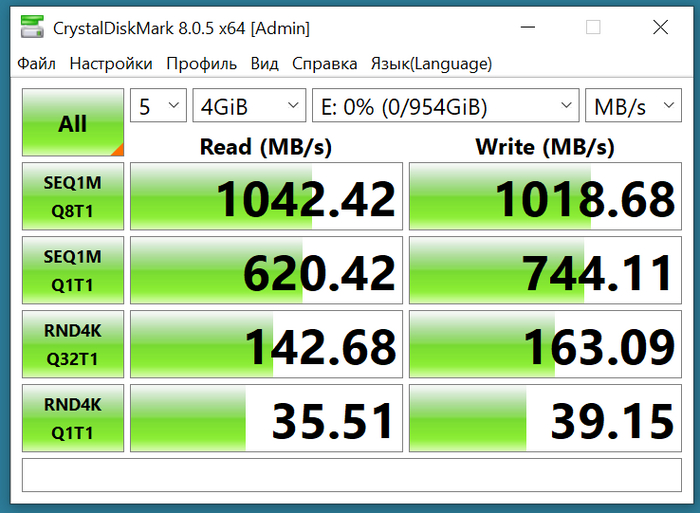

При подключении к ноуту по type C скорость - предел кабеля и/или стандарта (если у кого была выше, пишите в комменты)

Далее, как в прошлой статье про hdd->ssd:

1) клонируем с помощью Macrium Reflect Free Trials

2) двигаем раздел IM-Magic Partition Resizer Free

1) софт Macrium качается после регистрации на сайте

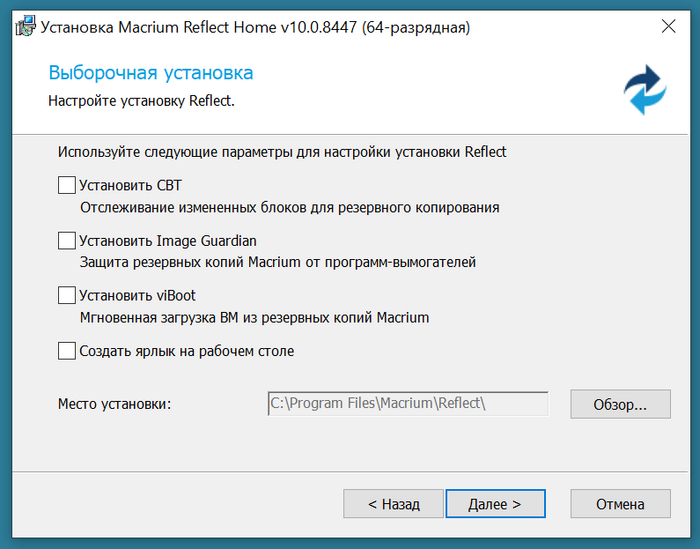

При установке галки можно не ставить, если нужно один раз клонировать диск

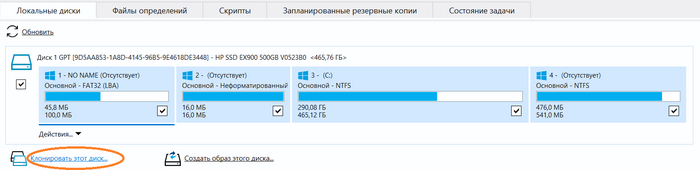

А дальше кликаем на не совсем очевидный пункт интерфейса "Клонировать этот диск"

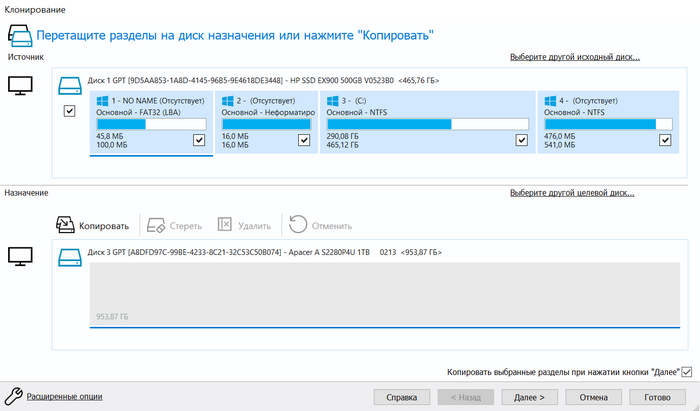

Клонируем один в один

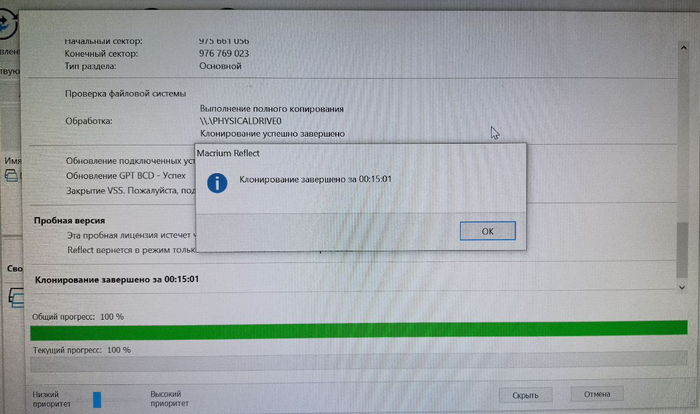

Клонирование 500Гб заняло 15 минут (долго? пишите в комменты)

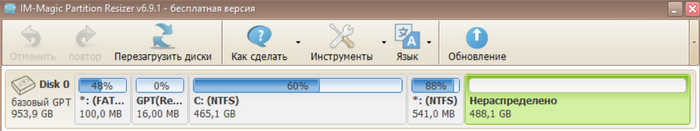

2) ресайзер у нас установлен 1-2 года назад, используем эту версию

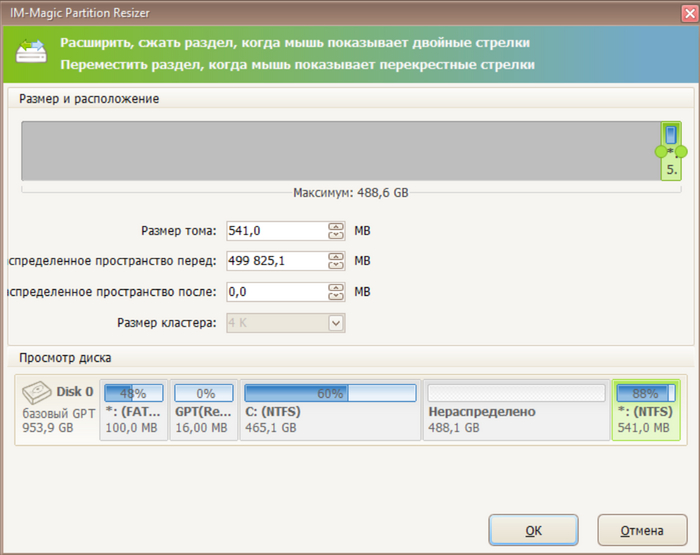

Сначала переносим в конец резервный раздел 500Мб

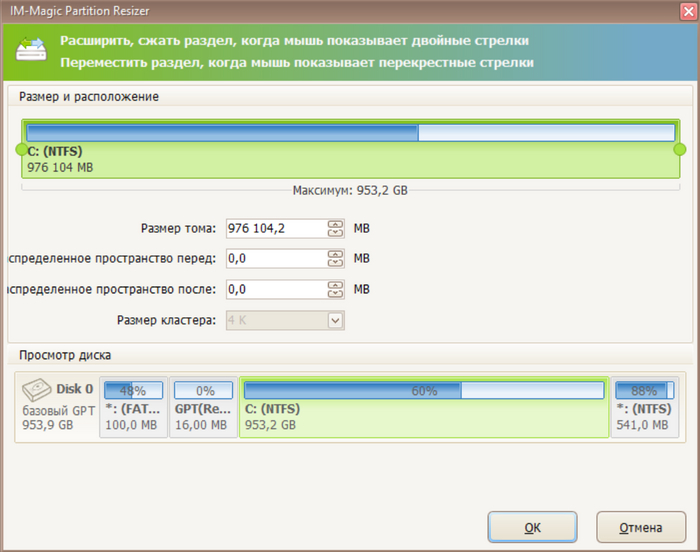

Потом расширяем основной раздел ntfs

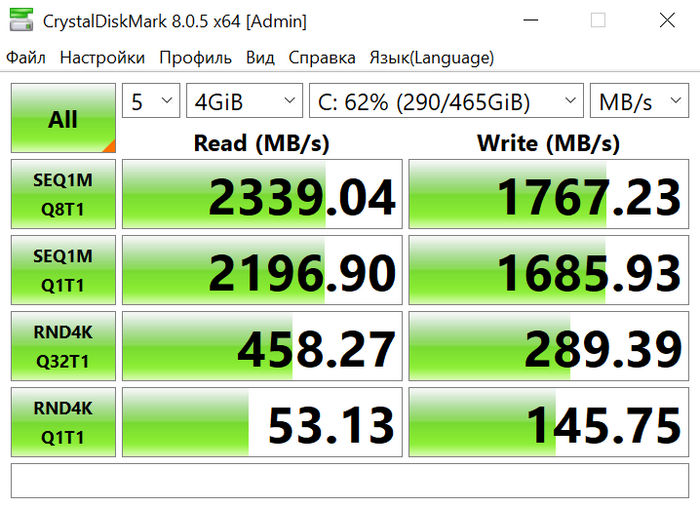

Расширение диска прошло за секунды, рестарт не требовался. Предыдущий диск HP 500GB M.2 2280 EX900 по скоростям вполне устраивал

Теперь с Apacer SSD AS2280P4U 1TB имеем хороший прирост скорости

Всем добра!

Как включить RPC?

Подскажите, может кто сталкивался в Windows 10 Pro в групповой политике отсутствует параметр "Настроить параметры подлключения RPC". Нужно добавить его

Разграничение прав на шары

Всем доброго времени суток!

Есть сервер SRV-JANUS (Windows2016 русская версия), на котором поднят контроллер домена POS.local. В домене есть два сайта internal (192.168.0.0/23) и external (192.168.5.0/24). Сервер SRV-JANUS смотрит в сайты двумя физическими портами (192.168.0.6 и 192.168.5.6).

Также на сервере поднят DFS с двумя расшаренными папками POS.local/Share/Обмен (физически расположена на E:/Exchange) и POS.local/Share/Общая (физически расположена на D:/Storage).

Нужно для папки POS.local/Share/Обмен дать доступ для всех пользователей домена, а для папки POS.local/Share/Общая дать доступ только доменным пользователям, которые авторизовались через компьютеры, которые входят в сайт internal. Причем пользователи могут авторизовываться под своей учеткой как в internal, так и в external.

Подскажите, пожалуйста, в какую сторону копать. Перепробовал и NTFS разграничение и DFS. Но уперся в то, что могу ограничивать только права пользователей без привязки к конкретным машинам.

Хабр пробивает донья или будьте осторожны в копроблогах - 03

Для ЛЛ: Мало кто знает, например, что у слова "дно" есть форма множественного числа - и это не "днища", а "донья". Про дичь и чушь в копроблогах Хабра.

На этот раз отличился копроблог RUVDS со статьей «Почему мы перешли на RAID 10».

Сначала вспомним базу.

RAID 0 - Striped Disk Array without Fault Tolerance.

Плюсы: пишем на все диски, читаем со всех дисков.

Write penalty – отсутствует.

Минусы: потеряли диск – потеряли данные.

Минимальное число дисков – 2.

RAID 1 – Mirror

Плюсы: пишем на все диски одинаковые данные, читаем со всех дисков.

потеряли диск – ну и ладно, считали все что было с оставшегося.

Write penalty – х2. То есть, чтобы записать 1 бит, надо выполнить и дождаться выполнения двух операций – на, условно, первый и второй диски, то есть на запись Mirror будет в два раза медленнее.

Минусы: полезная емкость - пополам (/2) для two-way mirror, бывает и 3-way

Минимальное число дисков – 2.

RAID 5 – одинарная четность.

Плюсы: пишем на все диски данные, и на один диск – итоги XOR. При выходе из строя любого диска – заменяем диск, применяем математику, восстанавливаем данные.

Write penalty (точнее, rewrite penalty) – 4, 4 операции: считать данные, считать четность, записать новые данные, записать новую четность.

Минусы: при выходе из строя еще одного диска – теряем данные.

Полезная емкость – N-1

Минимальное число дисков – 3 (данные, данные, четность)

RAID 6 – двойная четность.

Плюсы: пишем на все диски данные, и на два диск – на один xor, на другой другую математику. При выходе из строя любого диска – заменяем диск, применяем математику, восстанавливаем данные.

Точно переживет выход из строя еще одного диска.

Минусы: Write penalty (точнее, rewrite penalty) – 6, 4 операции: считать данные, считать две четности, записать новые данные, записать две новые четности.

Полезная емкость – N-2

Минимальное число дисков – 4 (данные, данные, четность, четность)

RAID 10 – собираем два Raid 1, из них собираем Raid 0.

RAID DP, Raid triple parity – тройная четность плюс немного математической магии.

Немного магии.

Все производители RAID, как совсем железных, так и программных, используют разные фокусы для ускорения работы. Тут и буфер чтения и записи на raid, и mirror accelerated parity (MS), и SSD буфер на запись, и Write Anywhere File Layout (WAFL) – когда данные не перезаписываются, а пишутся в новые адреса, много тут всякой магии.

И немного современности.

Современные all-flash СХД могут вообще не использовать Raid 10. Те же Huawei Oceanstor Dorado используют Raid-5, RAID 6, RAID-TP (см. OceanStor Dorado 6.0.0 Basic Storage Service Configuration Guide)

Плюсы очевидны, емкость не пополам, а -2, -3, что легко компенсируется дедупликацией и сжатием. Скорость отличная за счет внутренних буферов (на батарейке) по 512 мб и больше.

Современные гиперконвергентные системы и вариации на тему Redundant Array of Inexpensive Servers (RAIS) or Redundant Array of Independent Nodes (RAIN) вообще не оперируют терминами raid, вместо этого используя термины Redundancy Factor (RF) и failure to tolerate (FTT) – то есть, число единиц хранения, которые могут выйти из строя. Про это можно почитать

Design and Operation Considerations When Using vSAN Fault Domains

Fault tolerance and storage efficiency on Azure Stack HCI and Windows Server clusters

Теперь, вспомнив базу, пойдем к статье - Почему мы перешли на RAID 10, и с первой строки

Недавно у нас развалился RAID 5.

Вопрос в чем. Идет 2025 год. Калькуляторы надежности рейдов в зависимости от числа неустранимых ошибок и наработки на отказ давно написаны, хотя там можно и руками посчитать. С 2010х существует эмпирическое правило – из дисков выше 1 Тб строить только R6. Откуда у них взялся R5, на каких дисках и на каком устройстве вы это собрали и зачем?

Один из пользователей, чьи данные там были, очень живо интересовался тем, что за конфигурация у нас была. Вплоть до моделей дисков, дат их производства и серийных номеров. Он, вероятно, считал, что там стоит какое-то старьё

Он мог задать всего один вопрос. R5 ? Тогда мы не идем к вам. Так то серьезные дяди выкладывают статистики наработки разных моделей и партий дисков - вот тут, Backblaze Drive Stats for Q1 2024.

Потом очень искренне смеялся над фразой, что ни одна схема резервирования RAID не даёт стопроцентной гарантии сохранности данных.

Дает 99.9999 и еще сколько то девяток – скажем, метрокластер в RAID-TP. Вполне достаточно.

Раньше всё хранилось в RAID 5 (в абсолютном большинстве случаев)

В RUVDS – ни ногой, что еще сказать. Плюс, а что поверх? Автор пишет про диски на отдельном сервере, значит у них поверх намазано? А что? Что из SDS требует именно RAID ? Да, вроде бы, ничего, и более того, всему что я видел из RAIN – локальные raid прямо противопоказаны.

В большинстве случаев это рабочая ситуация.

В современном мире с текущей надежностью механических дисков это не рабочая ситуация. Похоже, в RUVDS не смогли даже в онлайн калькулятор надежности.

О чем я и пишу уже скоро год – идет медленное, незаметное, подгнивание качества ИТ кадров. Все было хорошо, а потом у них R5.

В RAID 10 — резервирование 2N: это два RAID 1,

Это не так. R10 не защитит от выхода из строя второго диска из пары, поэтому там надежность не 2N.

Фактически переход на RAID 10 означает плюс два или плюс три диска в каждый сервер. Это дорого: диски, конечно, — расходники, но при этом недешёвые.

Заявление на построение отказоустойчивости на уровне отдельного диска для хостинга означает отсутствие любой системы RAIN – то есть, при отказе не диска, а контроллера, точно получим недоступность, и возможно и потерю данных.

Это NVMe-RAID?

Нет. У нас везде — SSD: они хорошо соединяются в массивы.

NVME это интерфейс. То есть выбор интерфейса стоит между SAS, SATA и NVME.

SSD – стандарт диска, причем с уходом Optane – других и нет, выбор идет между QLC SSD vs. SLC vs. MLC vs. TLC.

Поэтому формулировка NVME RAID попросту бессмысленна, да и NVME SSD отлично собираются в RAID , хотя и с определенной потерей производительности, но я про это раньше писал.

Только это не нужно, точнее бессмысленно, если серверов хотя бы три и можно собрать RAIN. Лучше, конечно, 6 серверов. 8-10 в самый раз.

Кластер — это другой хороший отказоустойчивый подход. Но там уже сам кластер становится точкой отказа, и практика показывает, что не такой уж и редкой.

Почему сразу кластер? Можно хранить на внешней СХД. RAIN, нормальный , теплый и проприетарный, тоже не взрывается, кроме как от кривых рук.

Вместо заключения.

Всего на хабре 400-500 активно голосующих участников, и число голосующих который год падает. Статья набрала сотню плюсов, а точнее +78 и -2. То есть 78 человек из 400 считают статью с кучей ошибок – вполне нормальной. Ну что тут сказать. Допустим 10-20 голосов это чистая накрутка, и остается 50\500, 10% людей, которых к системам хранения пускать нельзя.

Silent Data Corruption , она же bit rot – вот и она, только в кадрах - люди принципиально не понимают, что тут не так

Сколько кнопок было на вашем тамагочи: три или четыре?

Четыре — это на богатом, три — это на каноничном. В нашем тамагочи, конечно, три. Заходите в игру и вырастите очаровательную квокку.